-

Vous êtes ici :

- Accueil

- Publications

- Bases

Sélectionner le numéro de "Bases" à afficher

Mode d’emploi pour mettre en place une veille sur Mastodon

À l’heure où le réseau social Mastodon profite des mésaventures de Twitter au point d’être parfois présenté comme une véritable alternative décentralisée, il est temps de se demander : comment faire de la veille sur Mastodon ?

Et le moins qu’on puisse dire, c’est que ce n’est pas intuitif. Malgré des similarités visuelles avec Twitter, Mastodon n’a pas du tout le même mode de fonctionnement ni les mêmes fonctionnalités.

Nous sommes donc partis d’un exemple concret : réussir à mettre en place sur Mastodon une veille métier autour de la veille, sujet ô combien important pour les veilleurs pour rester à jour dans leur métier et dans leurs pratiques.

Car, si Mastodon souhaite avoir une chance d’exister face à Twitter, le veilleur doit pouvoir basculer ses précédentes activités de Twitter vers Mastodon. Mais Twitter reste difficile à détrôner. Il conserve une place très importante pour le professionnel de l’information notamment pour sa propre veille métier grâce aux nombreux experts et fonctionnalités avancées qui s’y trouvent.

Alors comment et surtout peut-on reproduire le même schéma sur Mastodon ? Pour y parvenir, il faut effectivement qu’il y ait suffisamment d’experts sur Mastodon qui publient sur la thématique ciblée et que Mastodon nous fournisse des fonctionnalités suffisamment abouties pour pouvoir rechercher des contenus, identifier des utilisateurs pertinents et suivre leurs publications. C’est ce que nous allons vérifier dans cet article.

Comprendre le fonctionnement de Mastodon

Mastodon est un réseau décentralisé. Au lieu de faire partie d’un seul réseau social, les membres appartiennent à différentes « instances ». Une instance est le nom donné par Mastodon pour désigner les différents serveurs qui hébergent les membres.

Toute organisation ou toute personne indépendante - qui en a les compétences techniques - peut créer le sien et héberger des utilisateurs. Chaque serveur a ses propres règles, et est interconnectable avec les autres serveurs, en fonction des personnes suivies par les utilisateurs. Chaque groupe correspond donc à un hébergeur (ou à un serveur).

En vertu de sa structure décentralisée, le moteur de recherche installé sur chaque serveur ne permet pas d’explorer l’ensemble des serveurs qui composent Mastodon, mais seulement la partie à laquelle sa propre Instance est connectée. C’est un point très important qu’il faut absolument garder en tête pour la suite.

Déjà abonné ? Connectez-vous...

Connexion

Histoire de l’art : Openbibart enrichit son corpus

Depuis quelques semaines, le moteur de recherche OpenBibArt fusionne non plus deux, mais quatre bases de données bibliographiques d’histoire de l’art occidental. On peut désormais y trouver les notices bibliographiques d’articles de périodiques, de livres, de catalogues d’expositions et de ventes publiés entre 1910 et 2007.

Le site, connu des historiens d’art, des chercheurs et plus largement des professionnels et amateurs d’art, regroupe désormais les bases suivantes :

- Deux bases pour le Répertoire d’Art et d’Archéologie (RAA) qui fournit des descriptions d’articles, de monographies et de catalogues de vente de plusieurs pays de 1910 à 1972, puis de 1973 à 1990.

- Le Répertoire international de la littérature d’art (RILA), service de résumé et d’indexation pour la littérature d’histoire de l’art créé en 1975.

- La Bibliography of the History of Art (BHA), pour les années de 1990 à 2007.

Auparavant, OpenBibart ne permettait la consultation « que » de 550 000 références, de 1973 à 2007, issues du RAA et de la BHA. Dix ans après sa création, le nombre de références indexées a ainsi doublé pour atteindre 1,2 million de notices bibliographiques, grâce au travail conjoint de l’Institut National d’Histoire de l’Art (INHA), du Getty Research Institute (GRI) et de l’Institut de l’Information Scientifique et Technique du CNRS (Inist-CNRS).

Déjà abonné ? Connectez-vous...

Connexion

Dialog enrichit sa gamme de stratégies clé en main pour le biomédical

Dialog Solutions vient d’ajouter trois stratégies prêtes à l’emploi (Hedges) aux sept qu’il proposait déjà dans le domaine biomédical.

La mise à disposition de requêtes préétablies existe depuis un moment déjà tant pour des serveurs/agrégateurs que pour des banques de données, mais font rarement l’objet de l’attention du public des pros de l’info.

Elles peuvent pourtant être appliquées telles quelles ou servir de base à la constitution de nouvelles stratégies de recherche.

Les requêtes proposées par Dialog sont consacrées, pour le moment, au domaine biomédical. Cela s’explique aisément par le fait que Dialog Solutions a une offre significative dans ce domaine.

Rappelons que Dialog a absorbé le serveur DataStar, qui avait déjà une belle offre dans le domaine. Ce dernier avait entre autres pour objectif de concurrencer le serveur allemand DIMDI et en outre était basé dans un pays - la Suisse - où sont établis de nombreux laboratoires pharmaceutiques.

Déjà abonné ? Connectez-vous...

Connexion

Google améliore la recherche : le point sur les nouvelles fonctionnalités

L’innovation et l’actualité chez Google ne s’arrêtent jamais et ces derniers mois ne dérogent pas à la règle.

Dans cet article, nous faisons le point sur ces innovations récentes et nous testons les fonctionnalités et les produits, dans une perspective de veille et de recherche professionnelles.

Les nouvelles fonctionnalités utiles pour le pro de l’info

En septembre dernier, Google a animé son rendez-vous annuel Search-On où il dévoile toutes ses nouveautés en lien avec son moteur et la recherche d’information.

À cette occasion, nous avons découvert de nouvelles fonctionnalités intéressantes.

Un nouvel usage des guillemets dans Google

Les guillemets dans Google ont toujours servi à rechercher des expressions exactes même si cela n’empêche pas Google de passer outre, de temps à autre, quand il le juge nécessaire.

L’usage des guillemets a récemment évolué, mais c’est au niveau des résultats que cela fait une différence. Les guillemets permettent toujours de rechercher une expression exacte, mais dans les résultats proposés, on peut maintenant visualiser un extrait du contenu contenant spécifiquement cette expression, ce qui permet donc de voir dans quel contexte l’expression est utilisée et déterminer la pertinence du résultat par rapport à ses besoins.

Lire aussi :

Nous avons testé Kagi Search, un nouveau challenger de Google (Bases N° 407 - oct 2022)

Nous avons testé Neeva, le moteur qui pourrait remplacer Google chez les pros de l’info (Bases N° 406 - sept 2022)

Déjà abonné ? Connectez-vous...

Connexion

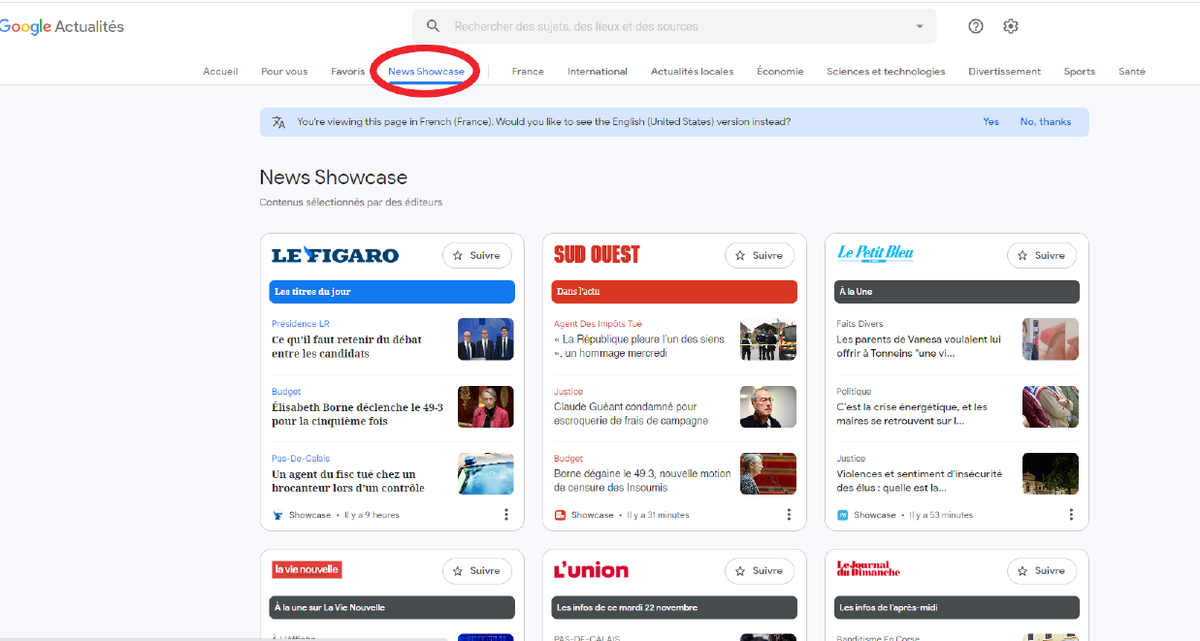

Google News Showcase : un nouvel espace pour les articles de presse nationale et régionale

Il y a peu Google a lancé en grande pompe son nouvel espace dans Google Actualités appelé Google Showcase.

Quelle place et quel intérêt peut-il avoir pour le veilleur ? C’est ce que nous avons exploré dans cet article.

Google News Showcase, qu’est-ce que c’est ?

Il s’agit d’un nouveau service destiné à mettre en avant les médias de référence d’un pays. Le service est proposé dans différents pays, mais seuls les médias du pays de l’internaute sont disponibles.

En ce qui nous concerne, Google Showcase dispose d’une page dédiée sur Google Actualités qui affiche une sélection d’articles issus de 130 médias français, essentiellement de la presse nationale et locale appartenant à de grands groupes de presse. Pour chaque média, on dispose de trois articles sélectionnés.

Chaque jour ces 130 médias choisissent quelques articles qu’ils mettent à disposition sur Google News Showcase. En échange, Google les rémunère.

Lire aussi :

Comment récupérer un flux RSS sur les moteurs web et Google Actualités ?

L’IA au cœur du nouveau Google Actualités : à réintégrer absolument dans son dispositif de veille

Sourcing : comment détecter des médias réellement nouveaux ?

Peut-on encore utiliser les kiosques numériques pour la recherche presse ?

Figure 1. Interface de News Showcase

Déjà abonné ? Connectez-vous...

Connexion

Comment intégrer les Google Ads et Facebook Ads dans sa veille concurrentielle ?

Lorsqu’on souhaite mettre en place une veille concurrentielle, une typologie de sources classiques est à surveiller : site du concurrent, presse nationale, locale, spécialisée, etc. La publicité en ligne comme les résultats sponsorisés et annonces publicitaires sur Google et Facebook peut également représenter une piste très intéressante.

Car comprendre la stratégie publicitaire d’un acteur peut en dire long sur sa stratégie globale à court, moyen et long terme. Quels produits ou services choisit-il de mettre en valeur, dans quels pays et quelles régions focalise-t-il ses actions ?

En matière de publicité en ligne, le marché est très largement dominé par Google et Facebook puis dans une moindre mesure Amazon. Ainsi, si nos concurrents ont choisi d’investir dans la publicité en ligne, il y a toutes les chances qu’ils aient choisi Google, Facebook ou bien les deux. Il va donc falloir trouver des solutions pour accéder aux données de Google Ads et de Facebook Ads.

Pendant des années, c’était tout simplement mission impossible, car ni Google ni Facebook ne partageaient librement la moindre donnée en la matière. Une veille sur la publicité en ligne ne pouvait donc se faire qu’en testant des requêtes susceptibles de faire apparaître les publicités de ses concurrents, ce qui ne fournissait que des résultats aléatoires et évidemment incomplets ou en faisant appel à des acteurs spécialisés sur les mesures d’audience et la veille publicitaire.

Lire aussi :

Information et publicité : des liaisons dangereuses pour la veille ?

Les demandes pour plus de transparence de la part des internautes, mais aussi des pouvoirs publics ont fait leur chemin et les différents acteurs ont donc commencé à fournir des informations sur les publicités qu’ils hébergent.

- Facebook s’est lancé le premier en 2019 avec la mise à disposition de sa Facebook Ad Library, une gigantesque base de données des publicités affichées sur le réseau social.

- Et c’est désormais au tour de Google de lancer une fonctionnalité permettant de connaître l’historique des annonceurs utilisant les Google Ads, c’est-à-dire les résultats sponsorisés. Elle avait été annoncée il y a un an, mais la fonctionnalité vient tout juste d’arriver à la fin du mois d’octobre en Europe.

- Amazon, quant à lui, ne semble pas avoir de politique de transparence en matière de publicité pour le moment.

Nous avons donc testé cette nouvelle fonctionnalité de Google pour voir comment on pouvait l’utiliser dans un contexte de veille concurrentielle et quelles étaient ses limites. Nous avons également testé de nouveau la Ad Library de Facebook dont nous avions déjà parlé lors de son lancement pour voir comment elle avait évolué et ce qu’il était toujours possible de faire.

Voir notre article « Publicité Web : un secteur en forte croissance à ne pas négliger pour la veille » - NETSOURCES n° 141 - juillet/août 2019

Déjà abonné ? Connectez-vous...

Connexion

Conférence AI-SDV 2022 : compte rendu de la dernière édition

L’opus 2022 de l’Artificial Intelligence Conference on Search, Data and Text Mining, Analytics and Visualization plus connue sous le vocable « AI-SDV » vient de se terminer dans une atmosphère particulière.

Si les contributions ont été, pour la plupart, de qualité et le réseautage efficace, nous retiendrons que c’est une manifestation de plus que les professionnels de l’information ne connaîtront probablement plus, la faute du Covid qui a « tué » la manifestation à petit feu.

Les plus anciens se souviennent d’un temps où les événements se bousculaient parfois à l’agenda, autant que le public à ces événements. Ces derniers risquent maintenant de se limiter aux dates proposées par l’EPO (European Patent Office) ou les groupes d’utilisateurs. Dans cet article, Benoit Sollie et François Libmann soulignent quelques présentations (disponibles sur Internet) et lignes de force qui ont marqué cette dernière édition.

Avant d’entrer dans le vif du sujet, signalons une coïncidence amusante : la manifestation qui regroupait 60 % des participants en présentiel et 40 % en vidéo avait lieu à quelques centaines de mètres des bureaux viennois de l’EPO. De plus, pour la première fois l’exposition n’avait pas fait le plein.

Déploiement de solutions IA « interne » : prévoyez de gros efforts

Wolfgang Thielemann a présenté l’ambitieuse plateforme de littérature scientifique développée par Bayer. Après cinq ans de développements et le travail constant de trois temps pleins (soutenus par des équipes de développeurs externes), la solution peut enfin être globalement déployée au sein du groupe.

Rappelons qu’elle héberge 250 millions d’enregistrements harmonisés, dont les entités et métadonnées ont été extraites par traitement de langage naturel (ou Natural Language Processing en anglais, NLP). La structure de la solution repose sur des ontologies. Le résultat est une interface dépouillée, permettant la recherche simultanée dans de nombreuses bases de données payantes (Elsevier, CAS, transferts technologiques). L’auteur a souligné les efforts fournis, l’architecture et les défis d’un projet d’une telle ampleur.

Déjà abonné ? Connectez-vous...

Connexion

Sciences ouvertes : l’alliance européenne universitaire EUTOPIA lance son propre portail de recherche

Eutopia est l’une des 44 alliances labellisées « Université Européenne » par la Commission européenne et vient de lancer un portail avec les publications de ses membres. Elle regroupe dix universités (pour un total de 100 facultés), dont celle de Cergy, en France.

Le portail commun à l’alliance (https://eutopia.openaire.eu/) suit deux objectifs majeurs :

1. Faciliter la visibilité des productions scientifiques et des chercheurs de l’alliance ;

2. Fluidifier le travail au sein de l’alliance.

Ce portail recueille, à l’heure où nous imprimons, plus de 570 000 publications (dont plus de 368 000 ouvertes) et 21 000 datasets de recherche. L’alliance est généraliste et le portail couvre donc de nombreux domaines, des mathématiques aux sciences naturelles en passant par la médecine ou l’informatique.

Lire aussi :

Le Canada explore un portail pour accéder aux résultats de la recherche canadienne

Pour réaliser le portail, les universités ont utilisé OpenAire, la plateforme européenne d’accès aux publications et datasets pour une science ouverte. C'est aujourd'hui une source importante pour trouver de l’information scientifique et académique et dont nous avons eu l’occasion de parler à plusieurs reprises dans BASES et NETSOURCES.

On notera que les publications présentes sur Eutopia alimentent également la plateforme générale OpenAire, de façon automatique.

Déjà abonné ? Connectez-vous...

Connexion

Le brevet est-il un signal faible pour l'innovation ?

On a pu assister ces dernières années à des progrès spectaculaires dans le traitement et l’exploitation des données : traitement du langage, analyse sémantique, réseaux de neurones ou IA, pour n’en citer que quelques-uns. Le monde du brevet n’échappe pas à cette tendance, et on a pu voir au cours des dernières années plusieurs initiatives dans les domaines de la traduction, de la classification automatisée ou de la recherche.

IPRally dont nous avons eu l’occasion de parler en détail dans le n° 395 de BASES de septembre 2021 est d’ailleurs un exemple concret de l’application de ces nouvelles technologies au service de la recherche dans les bases de données.

Sur quelles thématiques travaillent aujourd’hui les spécialistes du domaine ? Quelles futures révolutions nous attendent dans les années à venir pour la veille et la recherche d’information brevet ?

C’est ce que nous avons essayé de déterminer dans cet article avec une approche qui nous a paru originale : aller regarder dans les brevets eux-mêmes «ce qui les attend» à plus ou moins long terme - autrement dit , essayer de lire l’avenir du brevet en tant qu’objet d’innovation dans les brevets eux-mêmes.

Lire aussi :

Déterminer la valeur d’un brevet : des outils stratégiques pour l’entreprise

Nous avons testé IPRally, l'outil qui veut révolutionner la recherche brevets avec de l'IA

Espacenet, un acteur clé en mutation

The Lens, un outsider au fort potentiel pour la recherche brevet gratuite

En effet, les techniques évoquées plus haut (IA, analyse sémantique, etc.) peuvent faire, dans certains pays, l’objet de dépôt de demande de brevet.

Afin de garder le contact avec la réalité du terrain, nous avons complété notre interrogation brevets par l’avis d’un expert, Chief Product Officer de Questel-Orbit, sur sa vision du futur de la recherche brevet.

Quelques mots sur la méthode de recherche utilisée

Nous avons utilisé une combinaison des bases brevet Espacenet et d’Orbit Intelligence pour mener à bien notre recherche et l’analyse consécutive.

Déjà abonné ? Connectez-vous...

Connexion

Nous avons testé Kagi Search, un nouveau challenger de Google

L’heure est indéniablement aux bonnes nouvelles du côté des moteurs. Alors qu’il n’y avait jusqu’à présent aucune alternative crédible à Google sur le terrain des moteurs Web pour la veille et la recherche d’information professionnelle, on voit enfin arriver sur le marché une nouvelle génération de moteurs en phase avec les problématiques des professionnels de l’information.

Après le lancement du très prometteur Neeva (voir notre article « Nous avons testé Neeva, le moteur qui pourrait remplacer Google chez les pros de l’info », Bases N° 406 - sept 2022) voici venir un autre moteur tout aussi intéressant appelé Kagi Search.

Kagi a lui aussi opté pour un positionnement où la qualité des résultats et de la recherche et le respect de la vie privée priment. Et ce choix passe également par un modèle économique freemium.

Dans cet article, nous présentons en détail ce nouveau moteur, son positionnement et ses fonctionnalités et nous évaluons sa capacité à intégrer la panoplie des veilleurs et des professionnels de l’information.

Lire aussi :

Nous avons testé Neeva, le moteur qui pourrait remplacer Google chez les pros de l’info (Bases N° 406 - sept 2022)

Utiliser la fonctionnalité Goggles de Brave Search en complément de Google CSE (Bases N° 406 - sept 2022)

Nous avons testé Yep.com, un nouveau moteur de recherche à l’index maison (Bases N° 405 - août 2022)

La renaissance des annuaires sur le Web : comment les identifier et les utiliser pour vos veilles et recherches ? (Bases N° 402 - avril 2022)

Tout ce qu’il faut savoir sur Kagi Search avant de l’utiliser

Kagi Search (cf. Figure 1. Interface de Kagi Search) a été lancé en bêta publique le 2 juin dernier et a de nombreux points communs avec le moteur Neeva:

Un moteur sans publicité ;

- Un moteur qui privilégie et valorise les résultats pertinents et non commerciaux ;

- Un moteur avec de vraies fonctionnalités de recherche ;

- Un moteur qui ne collecte pas de données sur l’utilisateur ;

- Un moteur freemium (avec une version gratuite limitée) ;

- Un moteur personnalisable ;

- Un moteur qui valorise les retours et remarques de ses utilisateurs.

Mais au-delà de ces grands traits communs, Kagi Search a sa propre identité qu’il convient de bien comprendre avant de l’utiliser.

Déjà abonné ? Connectez-vous...

Connexion

Les Tags de Bases

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- moteurs académiques

- revues académiques

- sourcing veille

- flux RSS

- professionnel de l'information

- dirigeant

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- agenda

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- biomédical

- Questel

- Dialog

- références bibliographiques

- thèses

- résumé automatique

- Bing

- open citation

- Scopus

- veille collaborative

- outsourcing

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- Corée du Sud

- Pressedd

- LexisNexis

- Newsdesk

- sourcing pays

- chimie

- e-réputation

- recherche publique

- droit d'auteur

- littérature grise

- archives ouvertes

- veille medias

- dark web

- veille commerciale

- trésor du web

- réseaux sociaux

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- Bluesky

- podcast

- dark social

- shadow social

- science ouverte

- open source

- veille technologique

- knowledge management

- littérature scientifique

- web of science

- derwent

- abstracts

- protocole

- Intelligence artificielle

- OpenAI

- Commerce conversationnel

- GEO

- veille automatisée

- agents conversationnels

- recherche biomédicale

- veille informationnelle